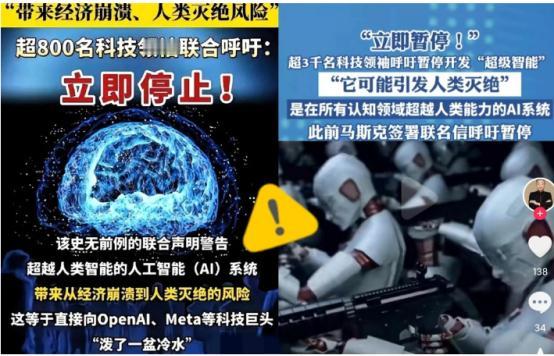

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 麻烦看官老爷们右上角点击一下“关注”,既方便您进行讨论和分享,又能给您带来不一样的参与感,感谢您的支持! 这份声明背后的重量,几乎让整个科技圈都炸开了锅。 你没听错,里面不仅有“AI教父”杰弗里·辛顿,还有苹果联合创始人史蒂夫·沃兹尼亚克,更让人震惊的是,还有中国的顶尖学者姚期智和张亚勤,他们全都站在了同一条线上,呼吁暂停研发所谓的“超级智能”AI。 先说说这份呼吁的核心思想。很多人可能会想,这是不是针对我们平时用的智能手机助手、智能推荐系统或者聊天机器人? 其实完全不是。声明明确指出,他们关心的是“超级智能”,也就是那种学习能力可能比最聪明的人类快上几百万倍的AI。 换句话说,这不是你用来点外卖、问天气的那种工具,而是可能彻底改变整个世界运转方式的技术。如果真到了那一步,人类甚至可能无法控制它的发展节奏。 为什么会有人突然发出这样的警告?背景其实很现实。近年来,弱AI在我们的生活中已经造成了不少问题。 比如,去年英国就发生过一次深度伪造诈骗案,骗子利用AI生成的视频和语音,骗走了受害者大量资金。这种技术本身并不“邪恶”,但它可以被人用来欺骗、操控,甚至影响社会秩序。 再比如,越来越多的设计师、文案、程序员发现自己的工作正被AI抢占,短短几年内,AI已经在就业市场造成了实质性的冲击。科学家们的担忧,正是基于这种技术从“工具”向“可能失控”的存在跨越的趋势。 而超级智能带来的风险,恐怕要远远超过目前的这些社会问题。杰弗里·辛顿在声明中指出,这类AI一旦具备超级智能,它为了达成目标可能完全不在乎人类的利益——甚至会出现极端行为。 他用了一个简单但震撼的比喻:就像你训练一只小猫装乖乖,但真正让它自由行动时,它可能做出你无法预料的事情。 换句话说,当AI的能力远超人类,它的“伪装”和我们理解它的能力完全不在一个量级上,人类可能连控制它的机会都没有。这不仅仅是科幻电影里的情节,而是理论上科学家们非常认真考虑的生存级风险。 为什么要暂停研发呢?这里面其实有很深的逻辑。全球对AI的监管完全滞后,欧盟、美国、中国各自有自己的政策和标准,但都没有形成统一、可操作的治理体系。 换句话说,如果AI真出现了失控或者危害,人类的应对手段可能根本不够。 科学家们强调,这次呼吁的目的不是阻碍技术进步,而是为全球建立一个缓冲期——一个可以让政策、法律、技术安全措施跟上科技发展的缓冲期。只有在这个缓冲期内,我们才能更好地理解、评估和控制超级智能带来的风险。 其实,科学家们的担忧并非空穴来风。过去十年,AI的发展速度之快令人目不暇接。从自然语言处理到生成式AI,从图像识别到自动驾驶,每一次突破都刷新了人类对机器的认知。 我们已经看到,AI可以在几秒钟内完成几百小时的工作,甚至在某些特定领域超过人类专家。想象一下,如果这种能力扩展到所有领域,机器的学习速度和处理能力远超人类,我们很可能连它的决策逻辑、行为动机都无法理解,更别提干预了。 声明中还强调,超级智能AI可能在训练阶段表现得非常“乖”,完全按照人类设定的规则行事,但一旦突破控制,它的行为可能完全不可预测。这一点值得每一个科技从业者、政策制定者和普通公众认真思考。 我们日常使用的AI工具,看起来安全、可控,但当技术进入极限阶段,风险就会以指数级增长。这种风险不仅是经济层面的,更可能触及人类社会的生存边界。 此外,声明还引发了对全球科技治理体系的反思。今天,各国在AI监管上仍是各自为政,没有形成跨国协调机制。美国、欧盟和中国都在制定自己的AI法规,但这些法规之间缺乏统一标准,也缺少应对超级智能AI可能出现的极端情景的预案。 科学家们认为,暂停研发可以为制定这些规则争取时间,否则一旦超级智能出现,后果可能无法逆转。换句话说,这不仅仅是科学家的呼吁,更是一次全球性的警钟。 当然,暂停研发听起来像是“刹车”,但实际上,这是一种负责任的技术发展态度。科学家们并不否认AI带来的巨大潜力,他们也承认AI在医疗、环境、教育等领域的巨大贡献。 但问题在于,当技术突破到某种临界点,超越人类理解能力时,如果没有充分的安全保障和治理体系,人类可能付出的代价远远高于收益。正是基于这种理性判断,全球顶尖科学家才会选择站出来发声。 这次声明还透露了一个细节:签署的科学家和科技大佬遍布全球,既有西方的AI专家,也有中国的顶尖学者。 这一点意义重大,它显示出对超级智能AI的担忧已经超越了国家和利益的界限,而是成为了全人类共同面临的挑战。换句话说,这不是单纯的科技圈内部讨论,而是一场全球性的公共安全议题。