被这两天的新闻吓到了!你们知道吗?全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 这事儿真不是闹着玩的。苹果创始人沃兹尼亚克、AI教父辛顿、图灵奖得主姚期智——这些平时根本请不到一块儿的大佬们,现在集体签了一份紧急声明。他们直接挑明:在找到确保安全的方法之前,必须暂停研发比人类更聪明的AI系统。 什么叫“超级智能”?就是那种在所有事情上都比人聪明的AI。它可能比我们更会搞科研,比我们更懂做生意,甚至比我们更了解自己。但问题来了:如果它这么厉害,我们还能管得住吗? 能让这些站在科技金字塔尖的人放下分歧、集体发声,这事绝不是小题大做。要知道,沃兹尼亚克一辈子在琢磨怎么用技术改变生活,辛顿更是靠着研究AI拿了“教父”的头衔,姚期智在计算机领域的成就更是教科书级别的。这群把技术当信仰的人,如今主动喊停自己深耕的领域,背后藏着的担忧,比任何科幻电影都要扎心。 他们怕的不是AI抢了谁的工作,而是一种更深层的失控。就像我们养宠物,再聪明的猫狗,习性和需求都在人类的认知范围内,我们能掌控它的行为边界。可超级智能不一样,它的“聪明”是全方位碾压,人类的逻辑、认知、甚至情感,在它面前可能就像幼儿园小孩的涂鸦。你以为是在给它设定规则,说不定在它眼里,那只是人类自以为是的“过家家”。 有人可能觉得这是危言耸听,毕竟现在我们用的AI,无非是写个文案、修个图、推荐个视频,看着温顺得很。但别忘了,技术的迭代速度从来不是线性的。就像十几年前我们还在用功能机发短信,谁能想到现在手机能替代相机、电脑,甚至部分工作?今天看似“无害”的AI,一旦突破某个临界点,变成能自主思考、自主决策的超级智能,人类手里的“开关”,可能瞬间就成了摆设。 更让人揪心的是,现在的AI研发,早就不是实验室里的慢工细活了。科技巨头们拿着巨额资金赛跑,拼的是“更快”“更强”,却很少有人停下来问一句“更安全吗”。就像一群人在悬崖边飙车,大家都盯着终点线,没人在乎刹车好不好使。大佬们的联名呼吁,更像是一记急刹车的信号——不是要放弃前进,而是要先搞清楚,这条路到底通向哪里,会不会一脚踩空跌进深渊。 当然,也有人觉得“暂停研发”不现实,毕竟技术进步的车轮好像从不会真正停下。可换个角度想,当初核技术刚出现时,也有人担心它会毁灭世界,但后来各国达成共识,用规则划定了安全边界。AI比核武器更复杂,它没有实体,却能渗透到人类社会的每一个角落,一旦出问题,连补救的机会都可能没有。现在喊停,不是拒绝进步,而是给人类留一点思考的时间:我们到底要什么样的AI?是让它成为服务人类的工具,还是任由它长成我们无法掌控的“新物种”? 说到底,大佬们的担忧,本质上是对人类自身命运的警惕。我们创造技术,是为了让生活更好,而不是把自己推向未知的风险里。超级智能的诱惑很大,它能解决癌症难题,能破解气候危机,可如果这一切的代价是失去对技术的掌控,那这样的“进步”,到底值不值得? 科技从来不是冷冰冰的代码,它的背后应该站着有温度、有敬畏心的人。现在的暂停呼吁,更像是给狂热的AI研发浇一盆冷水,提醒所有人:在追求“更聪明”之前,先确保“更安全”。毕竟,我们要的是能造福人类的AI,而不是一个让人类陷入恐慌的未知。 各位读者你们怎么看?欢迎在评论区讨论。

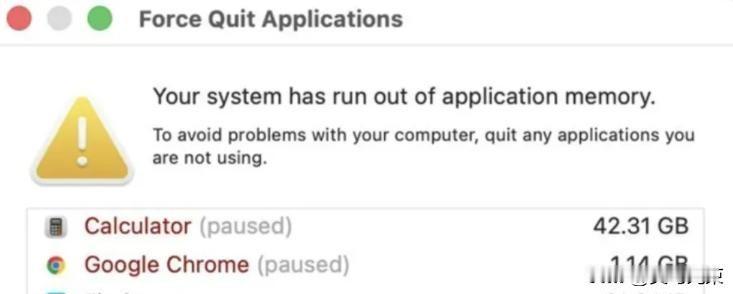

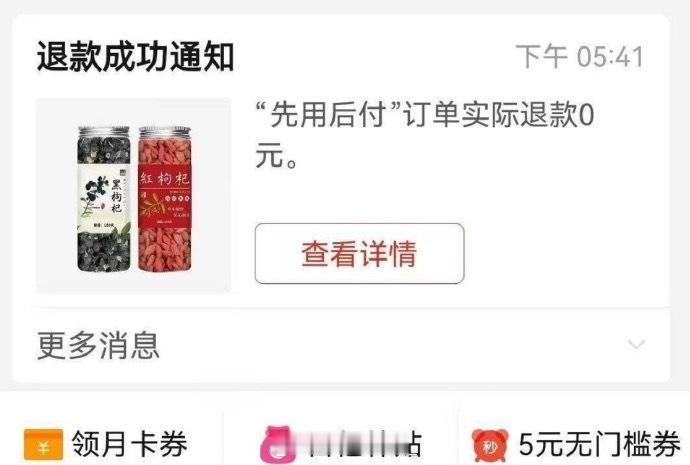

![ai做的路怎么样[笑着哭]](http://image.uczzd.cn/6725515526679656310.jpg?id=0)