DeepSeek创始人梁文峰再次语出惊人!他说:“我们经常说中国AI和美国有一两年差距,但真实的差距是原创和模仿之差。如果这个不改变,中国永远只能是追随者,所以有些探索也是逃不掉的。” 先说最核心的底层技术,美国那边早已跳出“做个模型”的层面,开始往产业链最上游钻了。就拿 OpenAI 来说,这公司现在根本不满足于当英伟达的“大客户”,前段时间直接宣布和博通联手搞自研芯片,要在2029年前搞出10GW级的专用芯片系统,等于自己动手定义硬件规则了。 反观咱们这边,不少大模型看着参数唬人,动辄千亿级,但掀开技术盖子一看,底层的核心架构还是绕不开人家先搞出来的那套基础框架,所谓的“创新”更多是在上面修修补补,比如优化训练速度、适配国内场景,本质上还是“在别人的地基上盖房子”。 百度的文心大模型算国内顶尖的了,2024年搞出的高效训练框架把吞吐速度提了4.1倍,还能降低成本,但这些都是工程层面的优化,没跳出既有技术路径,跟 OpenAI 从硬件到软件全链条原创的玩法根本不是一个量级。 再看算力这个硬骨头,这更是把“模仿型发展”的短板暴露得淋漓尽致。现在全球 AI 圈都得给英伟达交“芯片税”,这家公司掌控着超过 70% 的 AI 芯片市场,一块顶级芯片卖6万美元,咱们想买还得排队。 OpenAI虽然也用英伟达芯片,但人家早就开始布局后路,一边跟甲骨文签3000亿美元的算力协议锁定基础资源,一边又给AMD投钱绑定供应,甚至还拿到了AMD10%的股份,等于把供应链的主动权抓在了手里。 咱们这边直到2025年,头部企业采购还在盯着英伟达的H800不放,DeepSeek 训练V3模型用的就是这种针对中国市场的低配版 GPU,不是不想搞自研,是真没人家那种从上游布局的原创底气。全球 AI 领域一年总支出都快到 1.5 万亿美元了,美国一家就占了 55% 的市场份额,靠的就是这种从芯片到模型的全链条掌控力,咱们光靠买硬件、调模型,根本没法真正追平。 更关键的是基础研究的投入差距,这才是原创能力的根源。2024 年咱们的基础研究经费花了2497亿元,看着不少,但占整个研发经费的比例才6.91%,连7%都没到。美国那边光是OpenAI 一家,两年内就把投资额从几十亿砸到了千亿甚至万亿级别,目标很明确,就是啃算力、底层算法这些硬骨头。 这种投入差异直接体现在成果上,OpenAI 的GPT系列每一代都能开辟新赛道,从对话到多模态再到智能体,每一步都是行业标杆;而咱们这边,拿得出手的成果大多是应用层面的,比如百度的智能体技术用在商家营销、代码生成上,确实落地快、效果好,百度文库的智能 PPT 市场份额都占到八成了,但这些都是把现有技术变现,不是从零到一的突破。 梁文峰自己团队倒是搞出了点原创动静,DeepSeek-R1 成了首个经过同行评审的主流大模型,还登上了《自然》封面,V3 模型用 557.6 万美元就训练出来,成本只是 GPT-4o 的十分之一,但这更像个例,整个团队才139人,跟OpenAI的1200人根本没法比,能突围全靠极致优化,可这种“小而美”的创新,很难支撑起整个行业的原创转型。 行业里其实早就有感觉,咱们的AI发展有点“偏科”,应用落地快得惊人,金融、工业、交通这些领域到处都是 AI 的影子,但一碰到底层架构、核心算法这种需要长期啃硬骨头的地方,就显得力不从心。 就像梁文峰说的,不是差一两年的追赶时间,是路径上的根本区别,人家在造路,咱们在路边开店,店开得再大,路的控制权还在别人手里。以前靠模仿能快速跟上节奏,毕竟把别人的成熟技术拿来适配国内市场,省时省力见效快,但现在到了行业深水区,再这么下去就真成追随者了,美国已经开始自研芯片、定义新的技术范式,咱们要是还停留在优化模型、拓展应用的层面,迟早会被卡在关键环节。 DeepSeek自己的经历其实就是个缩影,靠架构优化和成本控制打出了名气,还逼得大厂跟着降价,但梁文峰比谁都清楚,这种“性价比优势”只是阶段性的,真要站稳脚跟还得靠原创。这也是他为啥反复强调“探索逃不掉”,毕竟AI这行跟别的不一样,没有原创的底层技术,再花哨的应用都是空中楼阁,人家一旦卡脖子,再好的落地场景也没用。 现在全球 AI 竞争早就不是比谁应用广、谁落地快,而是比谁能先搞出下一个“Transformer”、下一个“GPT”,这才是梁文峰这话里藏的真章,不搞原创,永远只能跟在别人后面跑。

出淤泥而不染

有什么可惊讶的,本来差距就很大,不是一、二个应用就能弥补的!底层逻辑差远了!

游戏人间

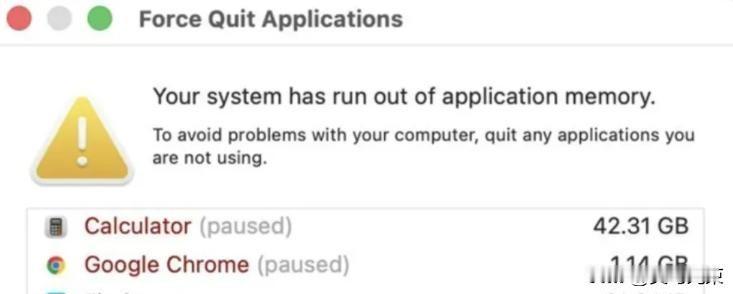

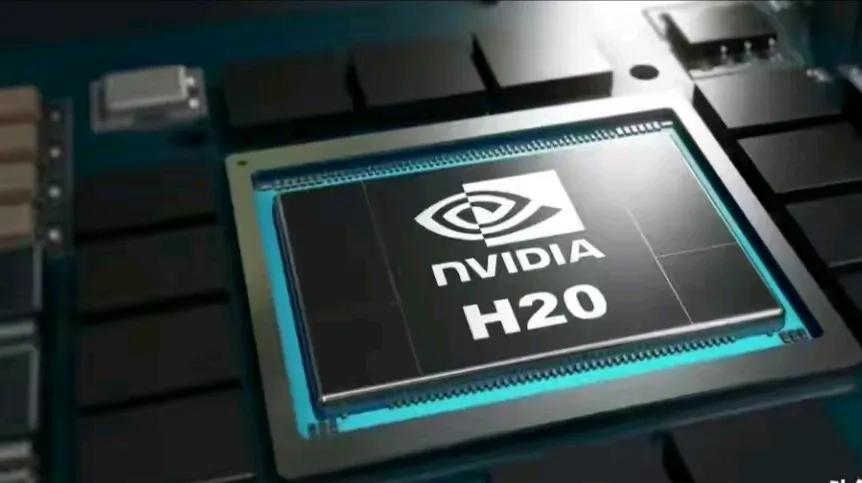

大陆的发展很多都是跟其他地方学的,跟欧美学,跟日韩学,跟港台学,自己独立创造的太少了,其实人家很难瞧得起。