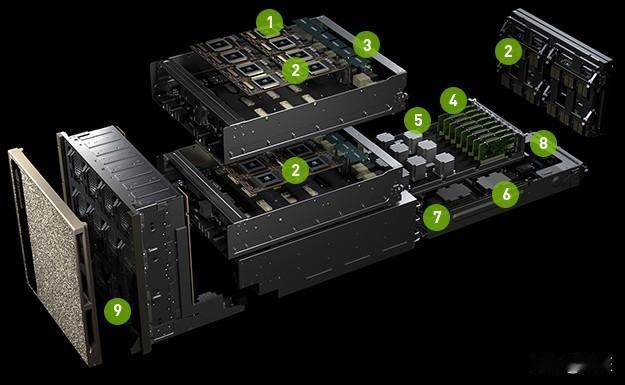

英伟达开源辅助驾驶模型和数据集2026ces 在 CES 2026 上,NVIDIA发布了 Alpamayo 系列开源模型、仿真工具和数据集。这事的核心意义在于:自动驾驶开始从看见就反应,走向先想清楚再动。过去的辅助驾驶,主要靠感知和规则。摄像头、雷达看到什么,就按既定逻辑给动作。这套方法在常见场景没问题,但一旦遇到少见、复杂、边缘情况,就容易不稳定。也正是这些场景,一直卡着高阶自动驾驶往上走。Alpamayo 想解决的,就是这个问题。它引入的是带推理能力的模型,不只是识别画面,而是把场景拆开,一步步判断,再做决定。换句话说,系统开始尝试理解“发生了什么”“接下来可能会怎样”,而不只是机械反应。同时英伟达还把大量极端和罕见场景的数据、以及配套的仿真工具一起开源。1700 多小时真实驾驶数据,覆盖不同地区和环境条件,相当于给行业准备了一套公开的难题集。算法行不行,不再只靠剪视频证明,而是能在同一套数据上被反复验证。把这两点放在一起看,Alpamayo 并不是多给一个工具,而是在推动一种变化。自动驾驶不再只拼谁跑得多、谁数据多,而是开始拼谁在复杂情况下判断更稳、逻辑更清楚、结果更一致。这件事对高阶自动驾驶尤其重要。真正决定安全下限的,从来不是日常通勤,而是那些低频但不能出错的场景。把这些问题摊到台面上,本身就意味着,这个领域正在走向更工程化、也更可被验证的阶段。英伟达开源辅助驾驶模型和数据集