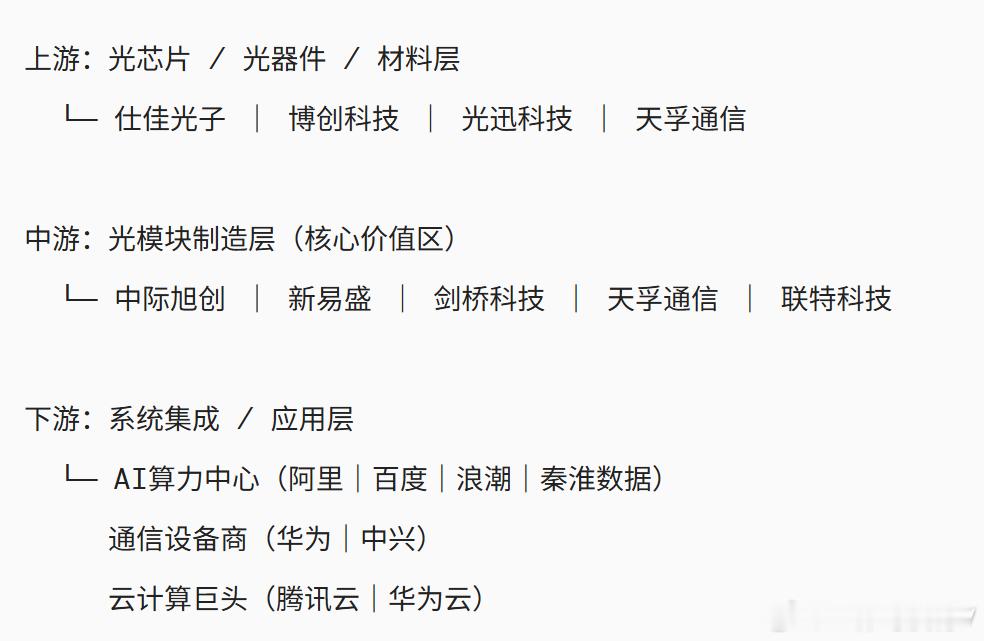

记者问:“中美 AI 差距到底有多大?” 梁文锋毫不避讳、一针见血地回答:“表面上中国 AI 与美国可能仅有一两年的技术代差,但真实的差距是原创和模仿之差。如果这个差距不改变,中国永远只能是追随者,所以有些探索是逃不掉的。” 咱们的工程能力绝对值得骄傲,这点没人能反驳。深度求索的V3模型,训练成本比美国同类低了90%;阿里云的通义千问,在海外市场也攒下了不少口碑。 这些都是实打实的硬本事,是咱们靠钻研拼出来的成绩。但掰开揉碎了看就会发现,1500多个模型里九成以上都在沿用2017年谷歌的Transformer架构。 过去十年里,从AlphaGo的强化学习到GPT的人类反馈训练,那些真正改变AI行业规则的突破。没有一个是咱们自主原创的,这才是最该警惕的地方。 这种差距其实就藏在日常的细节里。美国实验室发论文,敢把100种失败路径都写进去,咱们的企业却更爱说优化了哪个环节。不是不想探索未知,实在是环境没给太多试错空间。 国内AI公司找融资,投资人开口就问多久能赚钱。可美国的OpenAI烧了上百亿美元,投资人还在赌未来的通用智能。这种压力下,大家自然更愿意走稳妥的路。 吃透别人的算法再优化落地,三个月就能追上表面代差。可原创一个新架构,可能要三五年,甚至最后竹篮打水一场空。 算力和数据这两大基石,也面临着不小的挑战。2025年中国AI算力规模仅相当于美国的十分之一,不是没钱买芯片。是高端GPU被卡了脖子,好在咱们靠国产芯片加混合架构,硬是把模型训练了出来。 数据方面的差距更明显,美国有上百年的医疗、工业数据积累。咱们的高质量标注数据大多集中在垂直场景,通用领域的“富矿”还没挖透。 人才结构也存在短板,中国AI研究者数量超5万,稳居全球第一。但顶尖人才数量还不到美国的三分之一,不少顶尖学者在美国做原创研究。回国后带着成熟技术落地,虽加速了追赶脚步,却也让我们习惯了“拿现成的用”。 当然这并不意味着应用落地不重要,恰恰相反这是咱们的优势。政务、金融、物流这些领域,中国AI落地的深度和广度全球少见。就像北京市政交通一卡通靠AI优化,日均支撑千万级市民便捷支付。可没有原创这个“核心调料”,再精彩的应用也还是别人定义的菜式。 更关键的是创新生态的差距,美国形成了良性闭环。大学出理论,企业试错商业化,赚了钱再反哺科研。咱们的高校评估看论文数量,企业研发看短期KPI,缺了“允许失败”的缓冲带。 DeepMind花十年搞出AlphaFold,换在中国企业可能第三年就被砍掉。毕竟股东等不了十年,原创探索成了奢侈的选择。 如今咱们在工程创新上已做到极致,同样的模型能压缩得更小。跑得更快、成本更低,可底层算法没突破,优势就像在别人的赛道跑马拉松。暂时领先几百米,可赛道规则和方向都是人家定的。 2025年中国AI产业规模已破万亿,但90%利润来自应用层。基础层的芯片、框架、核心算法仍被卡脖子,这不是技术问题而是战略选择问题。 若继续把资源堆在应用优化上,再过十年可能还是“最好的追随者”。想要改变,就得在基础研究上下笨功夫,容忍慢、允许失败。 值得欣慰的是,清华在AI顶会论文数已紧逼谷歌,阿里千问也斩获国际大奖。这些都说明咱们有原创突破的潜力,AI的未来从来不是靠抄答案赢的。 面对万亿规模的AI市场,你觉得咱们该先稳住应用优势。还是咬牙投入原创探索?欢迎在评论区聊聊你的看法。