今天的AI热点新闻是三星搞出一个AI大模型,体积小1万倍的一个小小的 700 万参数模型在 ARG-AGI 1 和 ARC-AGI 2 的推理中击败了 DeepSeek-R1、Gemini 2.5 pro 和 o3-mini。它被三星称为“微型递归模型”(TRM)。

体积缩小 10,000 倍的模型怎么会变得更智能呢?

它的工作原理如下:

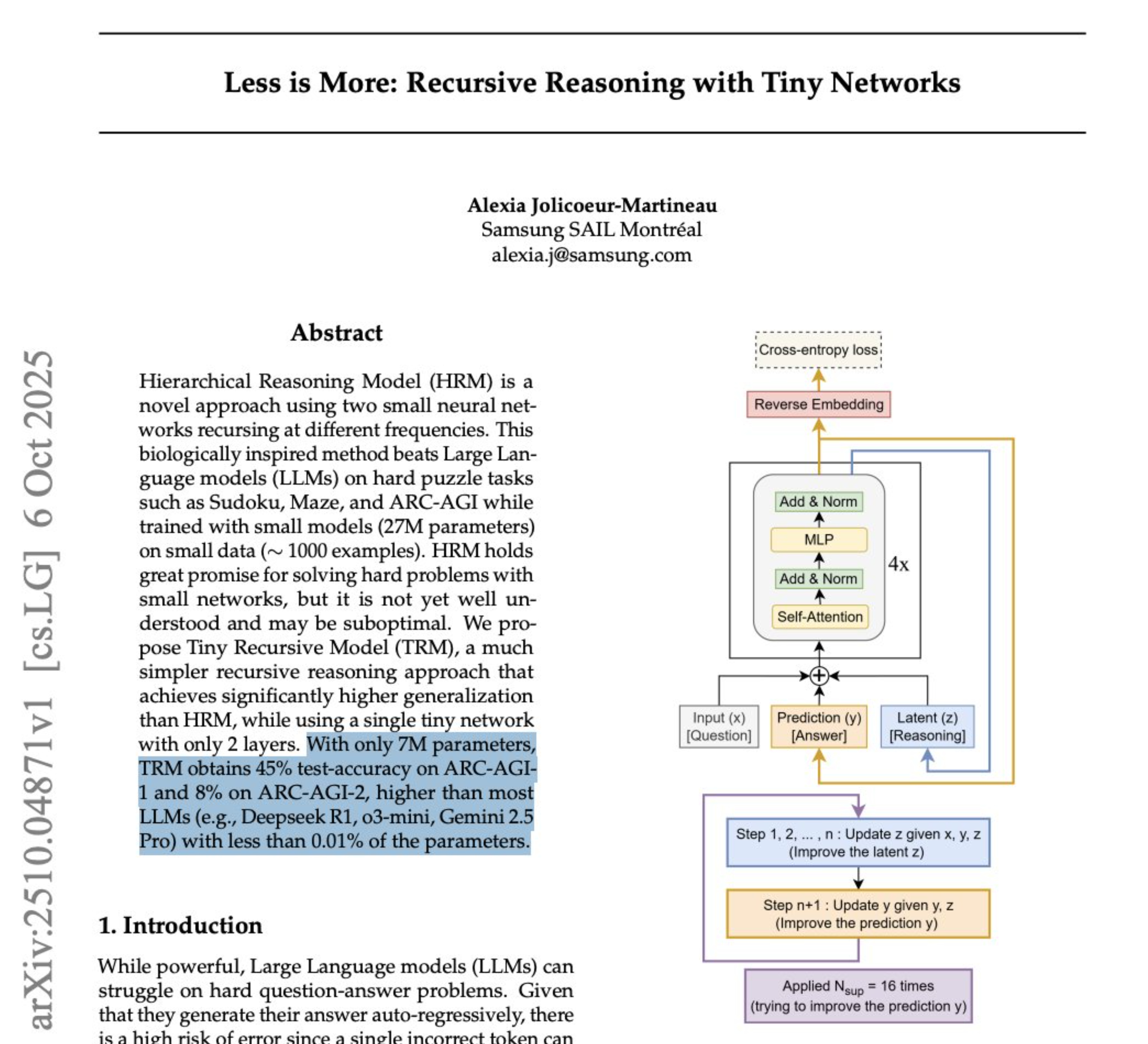

1. 起草初步答案:与逐字逐句撰写的LLM不同,TRM会先快速生成一份完整的解决方案“草稿”。这可以视为初步的猜测。

2. 创建一个“便笺簿”:它会为自己的内在思维创建一个独立的空间,一个潜在的推理“便笺簿”。真正的魔法就在这里发生。

3. 强烈的自我批评:模型进入一个强烈的内部循环。它会将草稿答案与原始问题进行比较,并在草稿簿上一遍又一遍地(连续6次)完善推理,并问自己:“我的逻辑站得住脚吗?错误在哪里?”

4. 修改答案:经过这种集中的“思考”,它会使用草稿中改进的逻辑来创建最终答案的全新、更好的草稿。

5. 重复直至确定:整个过程,从起草、思考到修改,最多重复16次。每次循环都会使模型更接近正确、逻辑合理的解决方案。

为什么这很重要:

商业领袖:这就是算法优势。竞争对手为暴力计算付出了巨大的推理成本,而更智能、更高效的模型只需极少的成本就能带来卓越的性能。

研究人员:这是对神经符号理论的一次重要验证。该模型在“行动”之前递归“思考”的能力表明,架构(而不仅仅是规模)可以成为推理能力的主要驱动力。

实践者:SOTA 推理不再受限于价值数十亿美元的 GPU 集群。本文提供了一个高效、轻参数的蓝图,用于构建可在任何地方运行的专用推理器。

这不仅仅是缩小规模;这是一种完全不同的、更加深思熟虑的解决问题的方法。