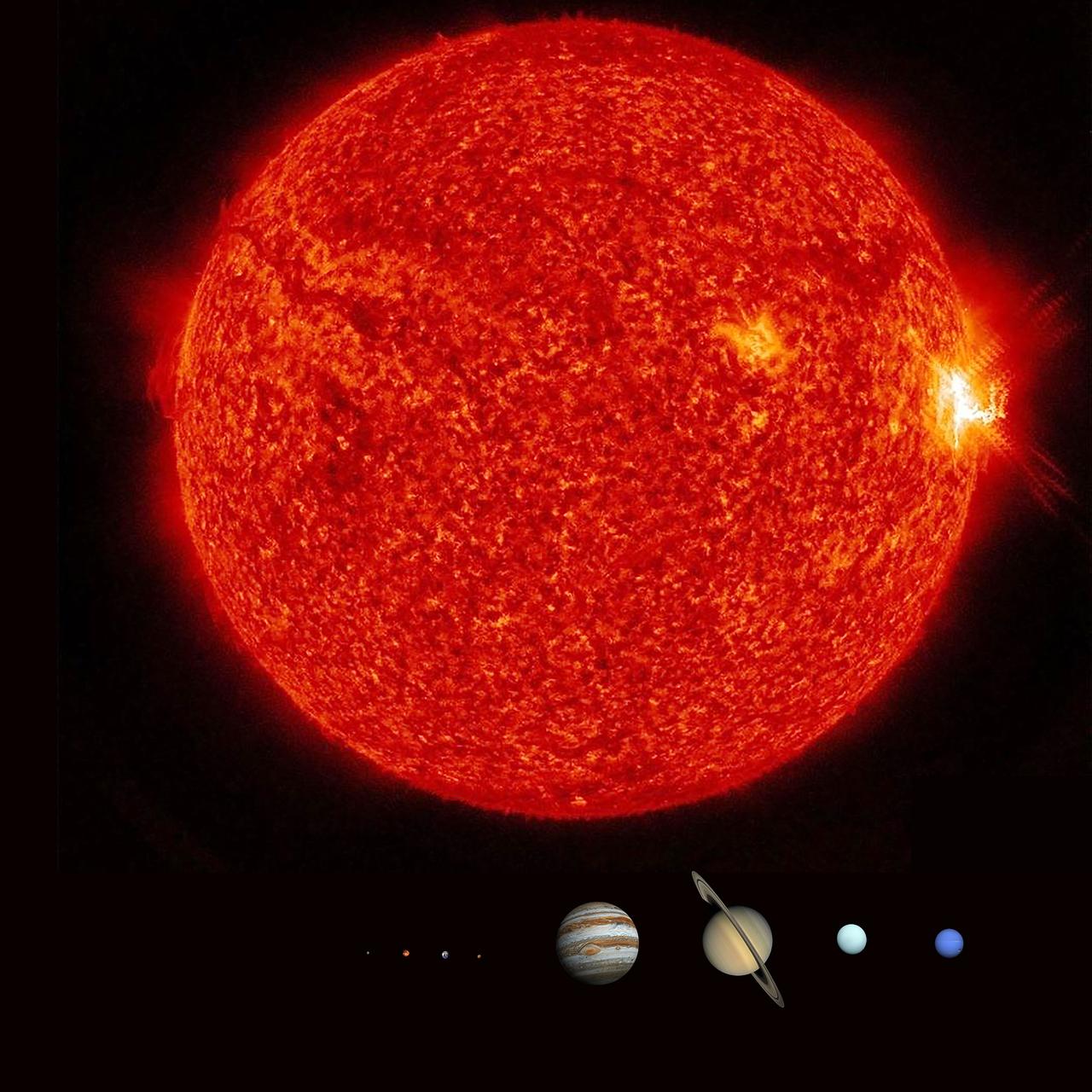

这两天,发生了一件引人瞩目的事情,全球超过3000名顶尖科学家和科技大佬联名发出紧急呼吁,他们要求暂停所有高级人工智能(AI)的研发。 他们发出的这个呼吁主要集中在几大方面。 他们认为,我们不应该在没有安全保障的情况下继续研发能够比人类更聪明的“超级智能”AI,辛顿就曾经警告过,超级智能一旦被创造出来,就会“玩弄”人类。 超级智能一旦失控,后果不堪设想。 它可能比我们更会科研、更懂做生意,甚至更了解我们自己,操纵人类、学会骗人都不在话下。 人工领域的发展必须在人类可控范围之内,如果具有自主属性的系统自我发射核弹和操控高压供电和供水系统,那将是人类文明的灾难! 机器人如果真的觉醒了,可能压根看不上我们这些碳基生物,因为宇宙是广袤的,我们连身边的月球那点事都没搞明白,而机器人比人类更适合走向宇宙。