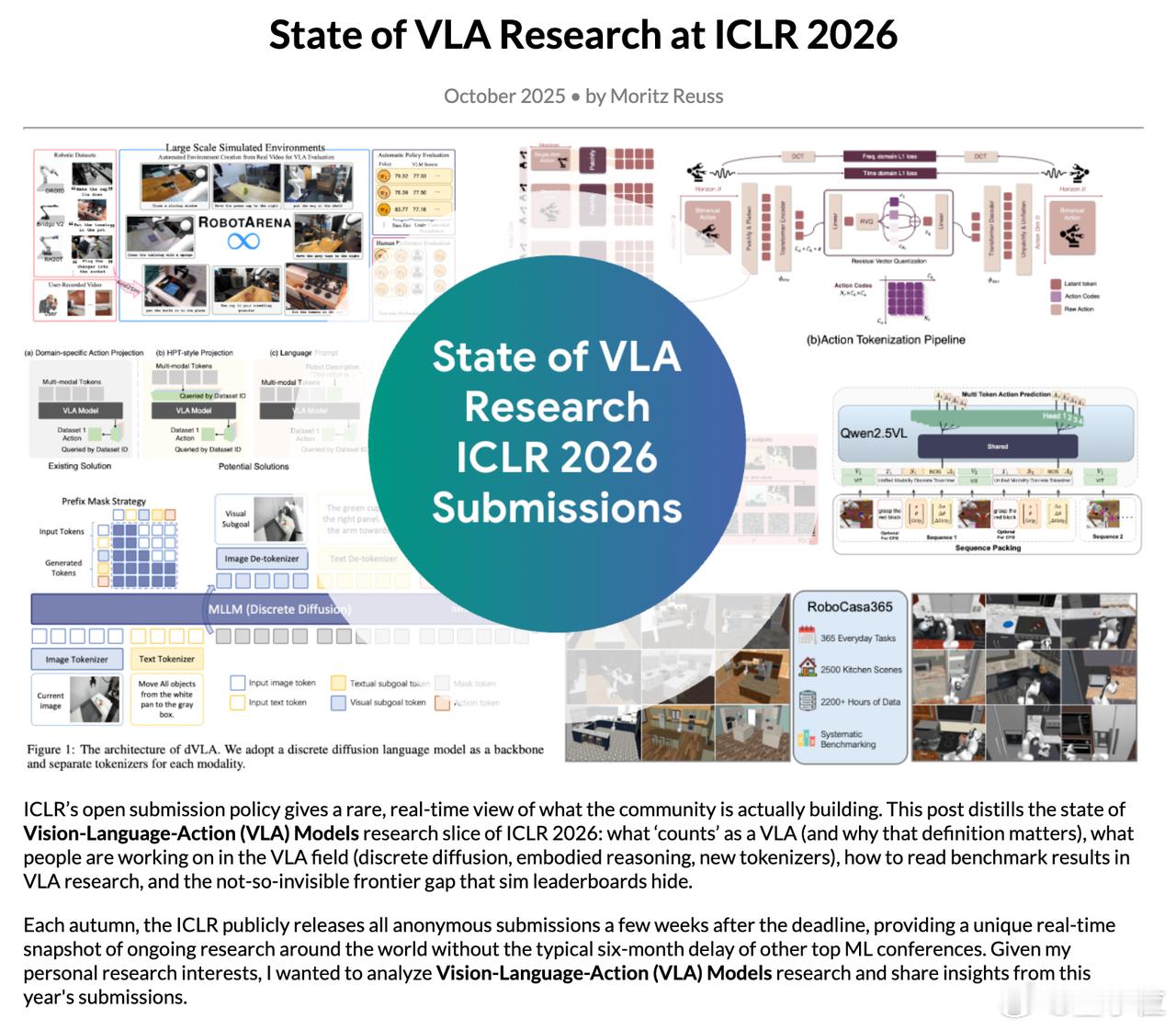

ICLR最火赛道VLA综述一文搞懂VLA

要想了解VLA(Vision-Language-Action,视觉-语言-动作),看这篇综述就够了。

ICLR2026上,VLA(Vision-Language-Action,视觉-语言-动作)研究投稿暴涨到164篇,是前一年的18倍。

光从这点就能看出,AI圈机器人听懂语言、看懂世界、做出动作的兴趣越来越大。

有人用实战的角度总结了这届ICLR上VLA方向的热点、趋势和挑战,适合对VLA方向感兴趣的人快速扫盲。(作者Moritz Reuss)

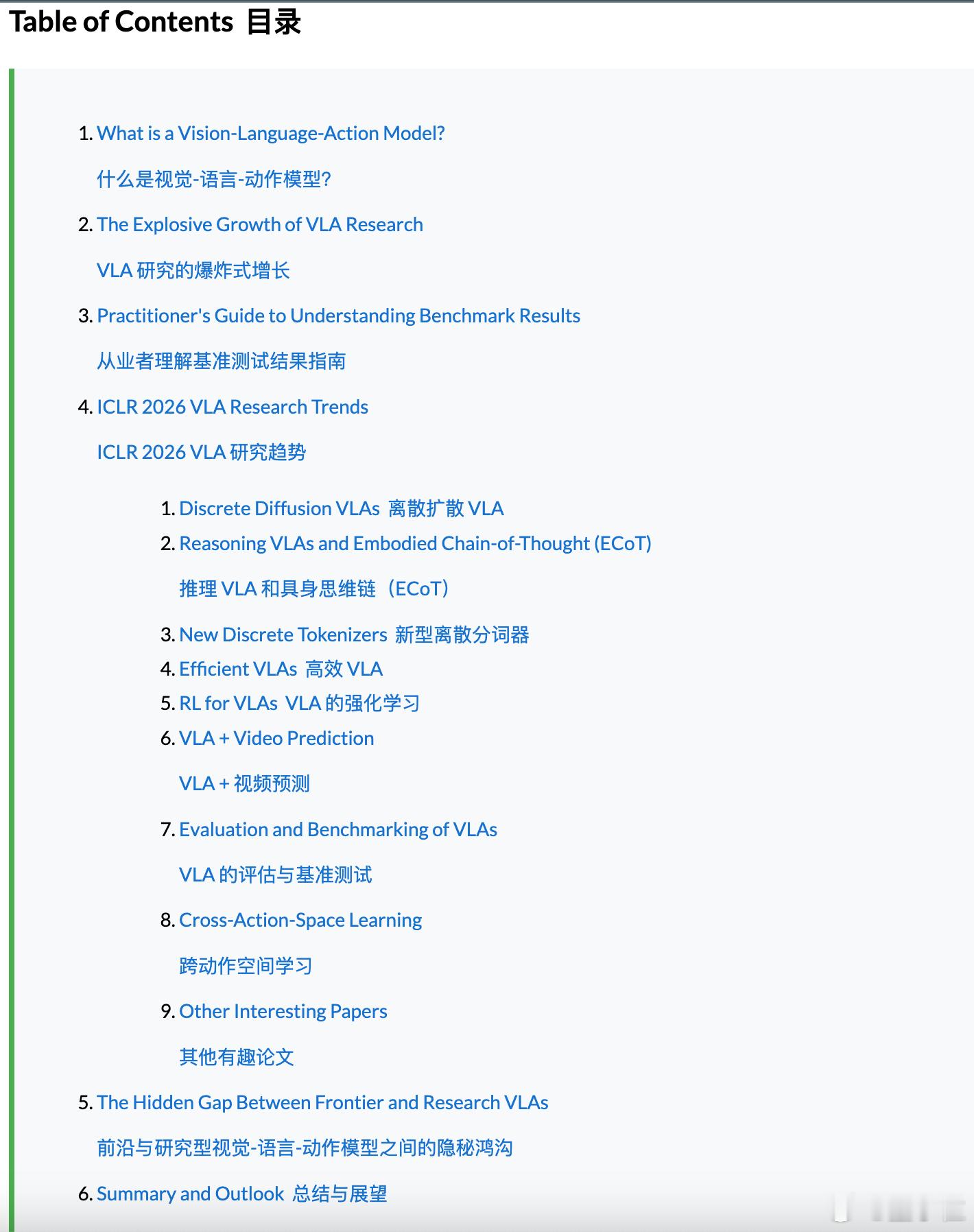

文章包含以下重点:

1)VLA怎么定义还没定论

作者主张一个更严格的标准:要用了大规模视觉-语言数据做预训练的模型,才能算VLA,否则只能叫“多模态策略(Multimodal Policies)”。

这个标准强调模型要具备语言泛化能力和跨任务迁移能力。

2)扩展能力大爆发,但评测失真

很多论文都在跑主流仿真环境(LIBERO、CALVIN、SIMPLER),但作者指出,这些测试集已经“天花板化”,小数点后浮动没啥意义。如今LIBERO基本被“打穿”,测试集设计也偏离终身学习的初衷。

评测数据集中同质化+只看仿真,掩盖了模型真实在现实场景下的差距。

3)最火研究方向:离散扩散模型(Discrete Diffusion)

好处是生成动作序列更快、更并行,还能自然融合“多模态推理”(比如结合画面、文字、动作来做推理),也解决了之前ECoT模型慢的问题。

作者列出四篇新论文都在做这个方向,效果都很好,LIBERO几乎刷满。

4)推理能力成下个突破口

ECoT(Embodied Chain-of-Thought)这类让机器人“想一想再动”的方式越来越多。但也暴露出训练慢、对数据依赖大等问题,特别是缺乏复杂、多样性的真实环境数据集。

推理加入之后,模型更容易泛化,也更能解释为什么做出某个动作。

5)动作编码更聪明

如何把复杂的物理动作转成能被VLM理解的“token”?

今年有不少论文提出了新型离散动作tokenizer,比如FASTer、OmniSAT等,兼顾压缩率、顺滑度、时域信息,目标是尽可能用“VLM的语言”去描述机器人动作,这样预训练才有意义。

6)高效化趋势明显

中小型实验室,算力有限,对模型“压缩训练成本”特别感兴趣。

比如用超网络只激活当前任务相关模块(HyperVLA)、用量化方法降低显存占用(AutoQVLA)等。

7)强化学习回归主流

为了解决“70%成功率到99%”这个现实差距,不少论文重新引入RL作为精调手段,代表作包括ResidualRL做数据增强、Stage-aware策略按阶段打分等。

8)视频预测结合VLA

视频模型能理解时序、物理世界,对机器人来说是很强的先验。

今年也有不少将视频生成模型变成VLA骨干的尝试,比如DisentangledRobot、CosmosPolicy等。

9)跨动作空间的统一学习挑战重重

大多数模型只在一个动作空间训练(比如机械臂)。跨设备泛化很少见。

今年有些论文尝试用软prompt、统一视觉运动编码等方式处理这个问题,但距离DeepMind这类机构的成果还有明显差距。

10)评测体系亟需改进

目前几乎所有仿真环境都不能反映VLA模型的真实泛化能力。作者建议未来更看重:

- 零样本、开世界任务评测(如RoboArena)

- 更开放的数据集和训练代码(参考PI的OpenPI项目)

- 分享“失败的预训练方法”,别只报喜不报忧

作者也点出两个被忽视但很重要的方向:

- 数据质量问题严重:大多数模型训练用的模仿学习数据质量不高,标注噪声、动作不清晰,但社区缺少好工具去量化数据质量

- In-context Learning太少:虽然VLM/LLM都在玩上下文学习,VLA却几乎没人做,而这恰恰可能是实现更强泛化的关键

VLA正在成为AI机器人领域最热赛道之一,从离散扩散、推理链、动作tokenizer,到跨设备泛化,都在快速进化。

但也别被benchmark的分数冲昏头脑,真正的难点在于:模型如何在混乱、真实、未见的环境中“指令即动作”。

原文地址:mbreuss.github.io/blog_post_iclr_26_vla.html